Solutions détaillées de neuf exercices sur l’indépendance linéaire (fiche 01).

Cliquer ici pour accéder aux énoncés.

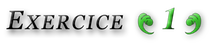

Le plus simple consiste sans doute à remarquer que :

![]()

En divisant par ![]() (pour

(pour ![]() puis en faisant tendre

puis en faisant tendre ![]() vers

vers ![]() on obtient

on obtient ![]()

On a donc, pour tout ![]() :

:

![]()

En divisant par ![]() puis en faisant tendre

puis en faisant tendre ![]() vers

vers ![]() on obtient

on obtient ![]() donc

donc ![]()

Il est alors clair que ![]()

Moralité : la famille ![]() est libre.

est libre.

On sait que :

![]()

![]()

Autrement dit : ![]() et la famille

et la famille ![]() est donc liée.

est donc liée.

Toujours grâce à la formule d’addition du sinus (cf. exercice précédent), on observe que chacune des applications ![]() et

et ![]() est combinaison linéaire de

est combinaison linéaire de ![]() et

et ![]()

Autrement dit, ![]() est une famille de trois vecteurs d’un espace vectoriel de dimension

est une famille de trois vecteurs d’un espace vectoriel de dimension ![]() (le plan engendré par

(le plan engendré par ![]() et

et ![]() Ceci entraîne que

Ceci entraîne que ![]() est liée : on sait en effet que dans un espace vectoriel de dimension

est liée : on sait en effet que dans un espace vectoriel de dimension ![]() toute famille comportant plus de

toute famille comportant plus de ![]() vecteurs est liée.

vecteurs est liée.

On peut aussi (mais c’est plus « savant ») invoquer le résultat général qui fait l’objet de l’exercice 8 de cette fiche.

La première affirmation est vraie car « toute sous-famille d’une famille libre est libre ».

La seconde affirmation est fausse. Un exemple : dans ![]() si l’on pose

si l’on pose ![]()

![]() et

et ![]() alors chacune des familles

alors chacune des familles ![]()

![]() et

et ![]() est libre mais la famille

est libre mais la famille ![]() est liée (puisque

est liée (puisque ![]() ou, si l’on préfère, parce que trois vecteurs d’un espace vectoriel de dimension 2 forment nécessairement une famille liée, ou encore et plus fondamentalement en raison du résultat de l’exercice 8 de cette fiche).

ou, si l’on préfère, parce que trois vecteurs d’un espace vectoriel de dimension 2 forment nécessairement une famille liée, ou encore et plus fondamentalement en raison du résultat de l’exercice 8 de cette fiche).

La troisième affirmation est fausse. Il se peut en effet que ![]() et que

et que ![]() soit libre.

soit libre.

Comme ![]() est liée, il existe des scalaires

est liée, il existe des scalaires ![]() non tous nuls tels que :

non tous nuls tels que :

![]()

Si ![]() alors l’un au moins des

alors l’un au moins des ![]() est non nul et

est non nul et ![]() ce qui montre que

ce qui montre que ![]() est liée : contradiction !

est liée : contradiction !

Donc ![]() et donc :

et donc :

![]()

Ainsi ![]()

Montrons que si ![]() est injective, alors toute famille libre de vecteurs de

est injective, alors toute famille libre de vecteurs de ![]() est transformée par

est transformée par ![]() en une famille libre de vecteurs de

en une famille libre de vecteurs de ![]()

Soit donc ![]() une famille libre de vecteurs de

une famille libre de vecteurs de ![]() et soient

et soient ![]() tels que

tels que ![]()

Comme ![]() est linéaire, cette condition montre que

est linéaire, cette condition montre que ![]() c’est-à-dire

c’est-à-dire ![]() puisque

puisque ![]() est injective.

est injective.

Mais comme ![]() est libre, on en déduit la nullité de

est libre, on en déduit la nullité de ![]() pour tout

pour tout ![]() La famille

La famille ![]() est donc libre.

est donc libre.

Montrons que si ![]() est surjective, alors toute famille génératrice de

est surjective, alors toute famille génératrice de ![]() est transformée par

est transformée par ![]() en une famille génératrice de

en une famille génératrice de ![]()

Soit ![]() Comme

Comme ![]() est surjective, il existe

est surjective, il existe ![]() tel que

tel que ![]() Puis, comme

Puis, comme ![]() est une famille génératrice de

est une famille génératrice de ![]() il existe

il existe ![]() tels que

tels que ![]()

Par linéarité de ![]() on en déduit que

on en déduit que ![]() On a bien montré que tout vecteur de

On a bien montré que tout vecteur de ![]() est combinaison linéaire de

est combinaison linéaire de ![]()

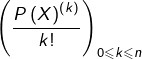

On va utiliser que le fait que, pour tout polynôme ![]() de degré

de degré ![]() et pour tout

et pour tout ![]() :

:

![Rendered by QuickLaTeX.com \[ Q\left(X+a\right)=\sum_{k=0}^{n}\frac{a^{k}}{k!}Q\left(X\right)^{\left(k\right)}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-e4d69d3984eff391e844ccedbe53b408_l3.png)

Soient ![]() tels que :

tels que :

![Rendered by QuickLaTeX.com \[ \sum_{j=0}^{n}\lambda_{j}\thinspace P\left(X+t_{j}\right)=0\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-c2d5d9ae91831dcd564dc770c9579170_l3.png)

Cette condition peut donc s’écrire aussi :

![Rendered by QuickLaTeX.com \[ \sum_{j=0}^{n}\left[\lambda_{j}\sum_{k=0}^{n}\frac{t_{j}^{k}}{k!}P\left(X\right)^{k}\right]=0\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-fcf7180e68b27a02c451d58f70addc75_l3.png)

![Rendered by QuickLaTeX.com \[ \sum_{k=0}^{n}\left[\sum_{j=0}^{n}\lambda_{j}\thinspace\frac{t_{j}^{k}}{k!}\right]\frac{P\left(X\right)^{\left(k\right)}}{k!}=0\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-c2c852a9fbe5caae793f6a7a15f32faf_l3.png)

La famille  étant libre (polynômes de degrés tous distincts), il s’ensuit que :

étant libre (polynômes de degrés tous distincts), il s’ensuit que :

![Rendered by QuickLaTeX.com \[\forall k\in\left\{ 0,\cdots,n\right\} ,\thinspace\sum_{j=0}^{n}\lambda_{j}\thinspace t_{j}^{k}=0\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-840a8711bc73617adbc2fa6f24a92964_l3.png)

Il s’agit d’un système linéaire et homogène en les ![]() qui est de Cramer car son déterminant est le déterminant de Vandermonde :

qui est de Cramer car son déterminant est le déterminant de Vandermonde :

![Rendered by QuickLaTeX.com \[ \left|\begin{array}{ccccc} 1 & 1 & \cdots & 1 & 1\\ t_{0} & t_{1} & \cdots & t_{n-1} & t_{n}\\ t_{0}^{2} & t_{1}^{2} & \cdots & t_{n-1}^{2} & t_{n}^{2}\\ \vdots & \vdots & & & \vdots\\ t_{0}^{n} & t_{1}^{n} & \cdots & t_{n-1}^{n} & t_{n}^{n} \end{array}\right|=\prod_{0\leqslant i<j\leqslant n}\left(t_{j}-t_{i}\right)\neq0\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-350e223fe4a44c9c140d127ec8fb8ddc_l3.png)

Par conséquent : ![]() pour tout

pour tout ![]()

On a prouvé que la famille ![]() est libre.

est libre.

Preuve de ![]()

Il s’agit de montrer la surjectivité de l’application

![]()

On va procéder indirectement et montrer plutôt son injectivité. Comme ![]() la conclusion résultera du théorème du rang.

la conclusion résultera du théorème du rang.

Soit donc ![]() Pour tout

Pour tout ![]()

![]() et donc, vu que

et donc, vu que ![]() est une base de

est une base de ![]() (famille libre de

(famille libre de ![]() vecteurs dans un espace vectoriel de dimension

vecteurs dans un espace vectoriel de dimension ![]() il s’ensuit que :

il s’ensuit que :

(![]() )

) ![]()

Ceci entraîne que ![]() (en effet, dans le cas contraire, on pourrait définir une forme linéaire prenant la valeur

(en effet, dans le cas contraire, on pourrait définir une forme linéaire prenant la valeur ![]() en

en ![]() il suffit pour cela de considérer la famille libre réduite au seul vecteur

il suffit pour cela de considérer la famille libre réduite au seul vecteur ![]() de la compléter en une base

de la compléter en une base ![]() de

de ![]() puis de définir

puis de définir ![]() par les images des vecteurs de cette base :

par les images des vecteurs de cette base : ![]() et

et ![]() pour tout

pour tout ![]() ).

).

Autre point de vue : on considère une base ![]() et les formes coordonnées associées

et les formes coordonnées associées ![]() pour

pour ![]() . La condition

. La condition ![]() entraîne que

entraîne que ![]() c’est-à-dire

c’est-à-dire ![]() .

.

Bref, ![]() et donc

et donc ![]() est injective.

est injective.

Preuve de ![]()

Il s’agit de montrer que ![]() est libre. Soient donc

est libre. Soient donc ![]() tels que :

tels que :

![Rendered by QuickLaTeX.com \[ \sum_{i=1}^{n}\lambda_{i}\varphi_{i}=0\qquad\left(\spadesuit\right)\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-b0c99d0938fb4a8b25d1060dc80b0d78_l3.png)

Attention : le zéro figurant au second membre désigne bien sûr la forme linéaire nulle.

Pour tout ![]() on peut associer par hypothèse au

on peut associer par hypothèse au ![]() uplet

uplet ![]() un vecteur

un vecteur ![]() tel que :

tel que :

![]()

En évaluant le membre de gauche de ![]() en

en ![]() on obtient

on obtient ![]()

Remarque : On a utilisé le symbole de Kronecker défini par :

![Rendered by QuickLaTeX.com \[ \delta_{i,j}=\left\{ \begin{array}{cc} 1 & \text{si }i=j\\ \\ 0 & \text{sinon} \end{array}\right.\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-17d813ab071803a1d8054da349fd5e83_l3.png)

Par hypothèse, il existe pour tout ![]() un couple

un couple ![]() tel que

tel que ![]() Posons :

Posons :

![]()

Alors :

![]()

![]()

![]()

La suite ![]() étant bornée, on peut d’après le théorème de Bolzano-Weierstrass en extraire une sous-suite convergente

étant bornée, on peut d’après le théorème de Bolzano-Weierstrass en extraire une sous-suite convergente ![]()

De même, la suite ![]() est bornée, donc la suite

est bornée, donc la suite ![]() aussi et l’on peut en extraire une sous-suite convergente

aussi et l’on peut en extraire une sous-suite convergente ![]()

En posant ![]() on constate que les suites

on constate que les suites ![]() et

et ![]() convergent l’une et l’autre, vers des limites respectives

convergent l’une et l’autre, vers des limites respectives ![]() et

et ![]() vérifiant :

vérifiant :

![]()

Nécessairement, ![]() Et comme

Et comme ![]() ceci montre que

ceci montre que ![]() est liée.

est liée.

Si un point n’est pas clair ou vous paraît insuffisamment détaillé, n’hésitez pas à poster un commentaire ou à me joindre via le formulaire de contact.