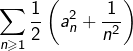

Pour tout couple ![]() de réels :

de réels :

![]()

Cette inégalité n’est qu’une reformulation de la relation ![]()

En remplaçant ![]() et

et ![]() par

par ![]() et

et ![]() respectivement, on voit que, pour tout

respectivement, on voit que, pour tout ![]() :

:

![]()

Comme la série  est convergente et vu que la série

est convergente et vu que la série ![]() converge par hypothèse, on conclut dans un premier temps que la série

converge par hypothèse, on conclut dans un premier temps que la série  converge, puis (avec le principe de comparaison) que la série

converge, puis (avec le principe de comparaison) que la série ![]() est absolument convergente (donc convergente).

est absolument convergente (donc convergente).

Plus généralement (et par le même argument ) : si les séries ![]() et

et ![]() convergent, alors la série

convergent, alors la série ![]() est absolument convergente.

est absolument convergente.

Ceci permet de définir un produit scalaire sur l’espace vectoriel des suites réelles de carré sommable, traditionnellement noté ![]() Il suffit de poser, pour tout

Il suffit de poser, pour tout ![]() :

:

![Rendered by QuickLaTeX.com \[ \left(a\mid b\right)=\sum_{n=1}^{\infty}a_{n}b_{n}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-2d29fe4726330f72ee43a8c8f33be1e9_l3.png)

On peut montrer, en outre, que ![]() est un espace de Hilbert (c’est-à-dire qu’il est complet pour la norme induite par ce produit scalaire).

est un espace de Hilbert (c’est-à-dire qu’il est complet pour la norme induite par ce produit scalaire).

En supposant que la série ![]() converge, il suffit de voir que :

converge, il suffit de voir que :

![]()

On peut aussi invoquer la règle des équivalents puisque, vu que ![]() (condition nécessaire de convergence), on a :

(condition nécessaire de convergence), on a :

![]()

Réciproquement, supposons la convergence de la série ![]() En posant, pour tout

En posant, pour tout ![]() :

:

![]()

![]()

C’est VRAI. En effet, pour tout ![]() :

:

![]()

Pour tout couple ![]() de réels strictement positifs :

de réels strictement positifs :

![]()

En appliquant ceci au couple ![]() il vient :

il vient :

![]()

![Rendered by QuickLaTeX.com \[\boxed{\frac{1}{n^{\ln\left(\ln\left(n\right)\right)}}\leqslant\frac{1}{n^{2}}}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-56fb1c41023259135018d94e2208290b_l3.png)

Finalement, d’après le principe de comparaison, la série proposée converge.

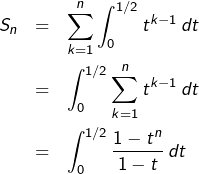

Posons, pour tout ![]() :

:

![Rendered by QuickLaTeX.com \[ S_{n}=\sum_{k=1}^{n}\frac{1}{k\thinspace2^{k}}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-574bd6b1fe9c1263d6109fa5c8b192ae_l3.png)

![]()

Il suffit alors de voir que :

![]()

![]()

Ainsi, la série la série  converge et admet pour somme :

converge et admet pour somme :

![Rendered by QuickLaTeX.com \[ \boxed{\sum_{n=1}^{\infty}\frac{1}{n\thinspace2^{n}}=\ln\left(2\right)}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-c314b271f2ae5c3c86a87617015f45ab_l3.png)

Dans l’exercice précédent, on a obtenu une formule intégrale pour le reste :

![Rendered by QuickLaTeX.com \[ R_{n}=\sum_{k=n+1}^{\infty}\frac{1}{k\thinspace2^{k}}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-8cc68a5d37ab9941fbbef81f9ee3a97f_l3.png)

![]()

![]()

Autrement dit, pour tout ![]() :

:

![]()

défaut) de

![]()

![]()

Avec Python, on peut écrire une fonction qui renvoie le plus petit entier naturel vérifiant ce type de condition :

def seuil(p):

n = 0

while ((n+1) * 2**n < 10**p):

n += 1

return n

On obtient ainsi :

>>> seuil(7)

19

Ensuite, il nous faut une fonction qui calcule la somme partielle ![]() pour un entier

pour un entier ![]() donné. On peut utiliser le module fractions pour calculer les sommes partielles de manière exacte :

donné. On peut utiliser le module fractions pour calculer les sommes partielles de manière exacte :

from fractions import Fraction

def sommePartielle(n):

s = Fraction()

for k in range (1,n+1):

s += Fraction(1, k * 2**k)

return s

Et voici le résultat :

>>> sommePartielle(19)

Fraction(10574855234543, 15256293212160)

qu’on peut d’ailleurs vérifier (le symbole _ fait référence au résultat précédemment calculé par l’interpréteur Python) :

>>> log(2) - _

9.119263222334695e-08

Tout ceci montre que le rationnel

![]()

Et si l’on veut on écriture décimale approchée :

>>> float(sommePartielle(19))

0.6931470893673131

d’où finalement :

![]()

Supposons ![]() et soit

et soit ![]() Alors pour

Alors pour ![]() convenable et tout

convenable et tout ![]() :

:

![Rendered by QuickLaTeX.com \[ \frac{\ln\left(\frac{1}{a_{n}}\right)}{\ln\left(n\right)}\geqslant\beta\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-6c3c687b47f5e750b97a471f790c7f4d_l3.png)

![]()

Si ![]() , alors à partir d’un certain rang :

, alors à partir d’un certain rang :

![Rendered by QuickLaTeX.com \[ \frac{\ln\left(\frac{1}{a_{n}}\right)}{\ln\left(n\right)}\leqslant1\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-afe37b9d6c90b70e7a7fb19740f7fde8_l3.png)

![]()

En revanche, on ne peut rien dire si ![]() En effet (dans ce qui suit, on suppose connues les séries de Bertrand) en choisissant :

En effet (dans ce qui suit, on suppose connues les séries de Bertrand) en choisissant :

![]()

![Rendered by QuickLaTeX.com \[ \frac{\ln\left(\frac{1}{a_{n}}\right)}{\ln\left(n\right)}=1+\frac{\ln\left(\ln\left(n\right)\right)}{\ln\left(n\right)}\rightarrow1\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-c97d39fda78bcc0f36845a457b54dd0a_l3.png)

![]()

![Rendered by QuickLaTeX.com \[ \frac{\ln\left(\frac{1}{a_{n}}\right)}{\ln\left(n\right)}=1+\frac{2\thinspace\ln\left(\ln\left(n\right)\right)}{\ln\left(n\right)}\rightarrow1\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-e054983ef9e65fda1ca2872ca5d40e6a_l3.png)

Une version plus simple de cet exercice consiste à calculer explicitement :

![Rendered by QuickLaTeX.com \[ A=\sum_{n=0}^{\infty}\frac{1}{\left(2n\right)!}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-ee14e3471a97c6daaee1f139059cef84_l3.png)

Si vous connaissez le développement en série entière de la fonction cosinus hyperbolique, alors tout est dit :

![]()

Mais on peut totalement se passer de cela et c’est même mieux, si l’on veut comprendre ce qui se passe. L’idée est d’ajouter membre à membre les égalités :

![Rendered by QuickLaTeX.com \[ e=\exp\left(1\right)=\sum_{n=0}^{\infty}\frac{1}{n!}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-b688522ce7bb4957a9aa220b46ce12e8_l3.png)

![Rendered by QuickLaTeX.com \[ \frac{1}{e}=\exp\left(-1\right)=\sum_{n=0}^{\infty}\frac{\left(-1\right)^{n}}{n!}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-86c3ad1b39f14086ab1bf2c805d784a7_l3.png)

la série des termes d’indice pair, d’où le résultat.

Le fait que ![]() soit un nombre dont la suite des puissances est de période 2 joue ici un rôle crucial. Il est donc naturel de chercher un nombre dont la suite des puissances serait de période 3.

soit un nombre dont la suite des puissances est de période 2 joue ici un rôle crucial. Il est donc naturel de chercher un nombre dont la suite des puissances serait de période 3.

Eh bien justement, nous connaissons un tel nombre ! Il s’agit de :

![]()

![Rendered by QuickLaTeX.com \[ \left\{ \begin{array}{ccc} e & = & {\displaystyle \sum_{n=0}^{\infty}\frac{1}{n!}}\\\\e^{j} & = & {\displaystyle \sum_{n=0}^{\infty}\frac{j^{n}}{n!}}\\\\e^{j^{2}} & = & {\displaystyle \sum_{n=0}^{\infty}\frac{j^{2n}}{n!}} \end{array}\right.\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-d89e1472689e76edd78c2c3f428545ea_l3.png)

Au membre de droite, on obtient le nombre complexe :

![Rendered by QuickLaTeX.com \[ \sum_{n=0}^{\infty}\frac{1+j^{n}+j^{2n}}{n!}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-b0d5c5668fadc37ab6169b0167c562b3_l3.png)

![]()

![Rendered by QuickLaTeX.com \[z_{n}=\left\{ \begin{array}{cc}3 & \text{si }n\equiv0\pmod{3}\\\\0 & \text{sinon}\end{array}\right.\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-217c7cb2ed0db72d2a41914af39c365f_l3.png)

Ainsi :

![Rendered by QuickLaTeX.com \[\boxed{\sum_{n=0}^{\infty}\frac{1}{\left(3n\right)!}=\frac{1}{3}\left(e+e^{j}+e^{j^{2}}\right)}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-eb1df8a1d6d8e52ed0f1dfaa9f230ef8_l3.png)

On peut améliorer un peu la forme du résultat. En effet :

![]()

![Rendered by QuickLaTeX.com \[ e^{j}=\frac{1}{\sqrt{e}}\left(\cos\left(\frac{\sqrt{3}}{2}\right)+i\sin\left(\frac{\sqrt{3}}{2}\right)\right)\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-357ca23af7f0ce2c3de01ef4f328de4c_l3.png)

![Rendered by QuickLaTeX.com \[ e^{j^{2}}=\frac{1}{\sqrt{e}}\left(\cos\left(\frac{\sqrt{3}}{2}\right)-i\sin\left(\frac{\sqrt{3}}{2}\right)\right)\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-bfe52dbac2ee45bf5fc1746038c88738_l3.png)

![Rendered by QuickLaTeX.com \[ \boxed{\sum_{n=0}^{\infty}\frac{1}{\left(3n\right)!}=\frac{1}{3}\left(e+\frac{2}{\sqrt{e}}\cos\left(\frac{\sqrt{3}}{2}\right)\right)}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-bf4f6773e837396767c7feb5210bb10e_l3.png)

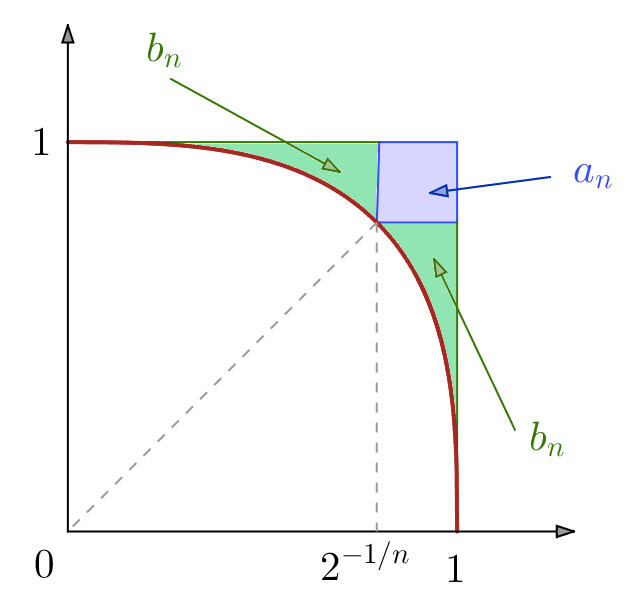

Il est clair que ![]() pour tout

pour tout ![]() On peut donc considérer l’application :

On peut donc considérer l’application :

![]()

Il s’agit d’une involution (c’est-à-dire que ![]() et son graphe présente donc une symétrie par rapport à la droite

et son graphe présente donc une symétrie par rapport à la droite ![]() d’équation

d’équation ![]()

Par ailleurs, ![]() est dérivable sur

est dérivable sur ![]() et pour tout

et pour tout ![]() dans cet intervalle :

dans cet intervalle :

![]()

ce qui montre que

L’abscisse du point d’intersection entre le graphe de ![]() et

et ![]() est :

est :

![]()

![]()

est l’aire du carré bleu

est l’aire du carré bleu est l’aire de chacune des régions vertes

est l’aire de chacune des régions vertes

de sorte que, pour tout ![]() :

:

![]()

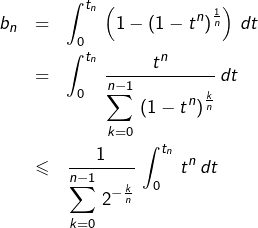

➤ Montrons maintenant la convergence de chacune des séries

![]()

D’une part :

![Rendered by QuickLaTeX.com \[\boxed{a_{n}=\left(1-t_{n}\right)^{2}\sim{\displaystyle \frac{\ln^{2}\left(2\right)}{n^{2}}}}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-65034cac872e4b92a1a036d226e853c9_l3.png)

D’autre part :

Mais :

![Rendered by QuickLaTeX.com \[ {\displaystyle \sum_{k=0}^{n-1}\,2^{-\frac{k}{n}}}=\frac{1}{2}\left(1-2^{-\frac{1}{n}}\right)^{-1}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-7479d06a10a24471ae1a3651aff5e59e_l3.png)

et :

![Rendered by QuickLaTeX.com \[ \int_{0}^{t_{n}}\,t^{n}\,dt=\frac{2^{-\frac{1}{n}}}{2\left(n+1\right)}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-a04264abc9e019968ed40519a31e5aab_l3.png)

donc :

![Rendered by QuickLaTeX.com \[\boxed{b_{n}\leqslant\frac{2^{-1/n}\left(1-2^{-1/n}\right)}{n+1}\sim\frac{\ln\left(2\right)}{n^{2}}}\]](https://math-os.com/wp-content/ql-cache/quicklatex.com-449f396a849eb6bb794cfd730aeda14e_l3.png)

ce qui prouve que la série

Finalement, la série ![]() converge.

converge.

Si un point n’est pas clair ou vous paraît insuffisamment détaillé, n’hésitez pas à poster un commentaire ou à me joindre via le formulaire de contact.